Aucun brevet ne protège l’intelligence artificielle, mais chaque décennie a vu surgir de nouveaux prétendants à sa paternité. Les travaux fondateurs de la discipline n’ont pas toujours porté ce nom, et les pionniers eux-mêmes n’étaient pas d’accord sur la définition exacte du concept.

Ce champ n’a jamais évolué de façon linéaire : les percées théoriques ont souvent précédé de plusieurs années, voire décennies, leur application concrète. Les premiers jalons de cette histoire sont issus de domaines aussi variés que la logique mathématique, la cybernétique et la philosophie.

Comment l’idée d’intelligence artificielle a émergé dans l’histoire des sciences

Le XXe siècle bascule, et un nouveau mot s’immisce dans le vocabulaire scientifique : intelligence artificielle. L’idée flotte déjà dans l’air depuis Descartes, qui s’interrogeait sur la possibilité de doter les machines d’une forme de pensée. Mais la véritable bascule intervient avec la montée en puissance de l’informatique. Alan Turing, figure majeure des mathématiques britanniques, propose dès 1950 une expérience pour évaluer la capacité d’une machine à simuler l’intelligence humaine. Ce test de Turing, désormais célèbre, ancre la réflexion dans le concret et fait passer la discipline de la spéculation philosophique à l’expérimentation.

En 1956, un petit groupe de chercheurs réunis à Dartmouth pose les bases d’une ambition commune : faire raisonner, apprendre, résoudre des problèmes à des machines. L’histoire de l’intelligence artificielle se tisse alors à l’intersection de plusieurs domaines, logique, cybernétique, traitement du langage, modélisation numérique. Norbert Wiener, à travers la cybernétique, imagine déjà le potentiel des automatismes et la manière dont les machines pourraient transformer la science.

Dans l’Hexagone, Jean-Gabriel Ganascia du CNRS revient régulièrement sur ce foisonnement. Pour lui, l’IA reste avant tout un champ de recherche évolutif, dont la définition change au rythme des percées en machine learning, deep learning ou vision par ordinateur. Les premiers systèmes pensants n’avaient qu’un objectif : reproduire le raisonnement humain. Rapidement, la réalité s’impose : le langage, la masse de données, la complexité de l’apprentissage dépassent de loin les modèles d’alors.

Voici les trois axes majeurs qui ont structuré les premiers travaux en intelligence artificielle :

- Traitement du langage naturel : permettre aux ordinateurs de comprendre et produire notre langue

- Réseaux de neurones : s’inspirer du cerveau pour créer des modèles capables d’apprendre

- Algorithmes d’apprentissage : extraire la connaissance des données massives

Qui sont les pionniers de l’IA et pourquoi leurs travaux ont marqué un tournant

L’essor de la recherche en intelligence artificielle doit tout à une poignée de personnalités audacieuses. Alan Turing, dès 1950, imagine son fameux test Turing : un jalon fondateur pour jauger la capacité d’un ordinateur à imiter la pensée humaine. Sa démarche ouvre de nouveaux horizons, du pur raisonnement logique aux premiers systèmes experts.

En 1956, lors de la conférence de Dartmouth, l’américain John McCarthy impose le terme « intelligence artificielle » et fédère une communauté ambitieuse. À ses côtés, Marvin Minsky, Claude Shannon, Allen Newell ou Herbert Simon s’emparent du sujet. Chacun s’illustre à sa manière : McCarthy développe le langage LISP, Minsky s’attaque à la modélisation du raisonnement, Shannon jette les bases de la théorie de l’information.

| Nom | Contribution |

|---|---|

| Alan Turing | Formalisation du test Turing, réflexion sur la pensée mécanique |

| John McCarthy | Création du terme intelligence artificielle, conception du langage LISP |

| Marvin Minsky | Développement de la modélisation du raisonnement et de la perception |

| Claude Shannon | Théorie de l’information, fondements du traitement du signal |

Dans les années 1940, Warren McCulloch et Walter Pitts proposent un modèle mathématique du neurone artificiel qui annonce les réseaux de neurones modernes. Plus tôt encore, Charles Babbage imagine la première machine à calculer programmable, lançant ainsi le calcul automatisé et le traitement de l’information sur des bases inédites.

Des premiers ordinateurs aux réseaux de neurones : les grandes étapes de l’IA

Le développement de l’intelligence artificielle suit de près les avancées en informatique. Dès les années 1950, les premiers ordinateurs franchissent un cap : ils s’attaquent à la résolution de problèmes, à la traduction automatique, à la reconnaissance de formes. Malgré l’enthousiasme, la réalité technique freine les ambitions : puissance de calcul limitée, attentes démesurées, résultats contrastés.

Un véritable changement s’opère dans les années 1980. Le machine learning s’impose, permettant aux machines d’apprendre à partir de données plutôt que de simples instructions. Les réseaux de neurones retrouvent un nouveau souffle. La France n’est pas en reste : Toulouse et Grenoble se distinguent, et le dialogue scientifique s’intensifie avec les laboratoires américains.

Un moment clé survient en 1997, lorsque Deep Blue, ordinateur développé par IBM, bat le champion du monde d’échecs Garry Kasparov. Ce duel, suivi par des millions de spectateurs, propulse l’IA sur le devant de la scène et alimente les débats bien au-delà des cercles de spécialistes.

Depuis, l’essor du deep learning rebat les cartes : traitement automatique du langage naturel, avancées en vision par ordinateur, reconnaissance vocale généralisée. Des géants comme Apple, Google ou OpenAI capitalisent sur ces progrès pour repenser la relation homme-machine. Les algorithmes s’infiltrent dans tous les secteurs et interrogent, au passage, la nature même de l’intelligence et ses frontières.

L’intelligence artificielle aujourd’hui : quels impacts sur notre quotidien et notre avenir ?

L’intelligence artificielle est désormais partout. Elle fait partie des usages quotidiens, passant des laboratoires aux poches de chacun. Nos smartphones, nos assistants vocaux, les recommandations que l’on reçoit en ligne : tout cela repose sur des algorithmes qui exploitent nos données à chaque interaction, adaptent les services, prédisent envies et besoins. Le traitement du langage naturel permet aujourd’hui d’échanger avec une machine, de traduire instantanément un texte, d’explorer des masses d’informations. Avec la vision par ordinateur, la santé, la mobilité ou la sécurité connaissent des mutations inédites : véhicules autonomes, diagnostics assistés, surveillance automatisée… La frontière avec la science-fiction s’efface peu à peu.

La France, de son côté, affirme sa singularité. Des chercheurs comme Jean-Gabriel Ganascia au CNRS nourrissent la réflexion éthique et dessinent de nouveaux modèles. À Paris, la mission portée par Emmanuel Macron vise à bâtir une stratégie nationale, entre ambitions industrielles et défense des libertés publiques.

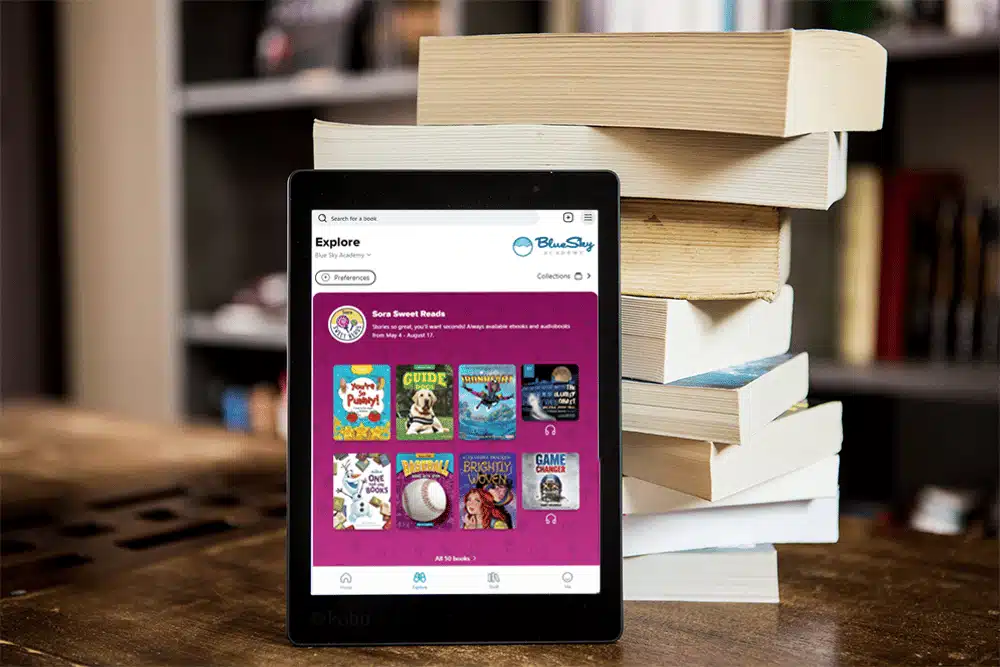

Les grandes firmes, de Google à Apple, intègrent l’IA dans leurs produits. Mais la compétition se joue aussi à l’échelle locale : la recherche sur l’intelligence artificielle irrigue la banque, l’agriculture, l’éducation. Les priorités s’affinent, automatiser, personnaliser, sécuriser, tandis que la souveraineté technologique et l’impact sur l’emploi deviennent des sujets de débat majeurs.

Voici quelques domaines où l’influence de l’intelligence artificielle se manifeste déjà :

- Santé : détection précoce des maladies, aide au diagnostic

- Éducation : suivi personnalisé, adaptation des parcours

- Mobilité : optimisation des transports, véhicules connectés

- Sécurité : analyse des flux, prévention des risques

La trajectoire de l’IA ne cesse de surprendre. Demain, qui saura dire quels nouveaux visages prendra l’intelligence artificielle, et jusqu’où elle repoussera les frontières de nos vies ?